Python kanns, Ruby kanns, Ja sogar Java kanns. Nur PHP nicht. Nun, das stimmt nicht so ganz, PHP kann es über Umwege doch. Wovon die Rede ist?

Objekte als Hashtabellen-Schlüssel verwenden

Wie der eine oder andere Anwender von PHP weiß, können assoziative Arrays nur Integer und Zeichenketten als Schlüssel verwenden. Das ist manchmal sehr schade und man muss auf andere Werkzeuge ausweichen, indem man sich z.B. mit array_unique() und ArrayAccess sowie Iterator selbst etwas zurecht schustert.

Es gibt allerdings auch eine relativ elegante Lösung für dieses Problem: Die SplObjectStorage Klasse

Mit dieser Klasse aus der PHP SPL ist es möglich eine Datenstruktur zu schaffen, die sich wie ein assoziatives Array verhält, zugleich jedoch auch Objekte als Schlüssel erlaubt. Ein kleines Beispiel:

1, 'prop2' => 2);

$obj2 = (object) array('prop1' => 11, 'prop2' => 22);

$obj3 = (object) array('prop1' => 11, 'prop2' => 22);

$objStorage = new SplObjectStorage();

$objStorage[$obj1] = 3;

$objStorage[$obj2] = 33;

$objStorage->contains($obj1); // TRUE

$objStorage->contains($obj2); // TRUE

$objStorage->contains($obj3); // FALSE

echo $objStorage[$obj1]; // 3

echo $objStorage[$obj2]; // 33

echo $objStorage[$obj3]; // UnexpectedValueException

Zu beachten ist, dass man zwar über ein Exemplar der Klasse SplObjectStorage iterieren kann, mit der $x as $y => $z Syntax jedoch unerwartetes Verhalten auftritt. In diesem Beispiel ist nämlich nicht $y das Objekt, sondern $z. $y entspricht der internen Position des Iterators. Nutzt man hingegen die $x as $y Syntax, ist $y das Objekt und man muss über $x[$y] auf dessen Wert zugreifen.

Ich hoffe ich konnte einen hilfreichen, wenn auch kurzen Einblick in die Klasse SplObjectStorage bieten. Dies war jedoch wirklich nur ein kleiner Ausschnitt, mehr kann über die Dokumentation erfahren werden.

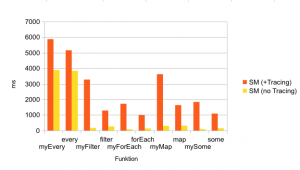

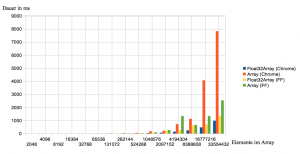

9 – 13 January our development team took the lead, with a staff introduction and surprising JavaScript lessons learned.

9 – 13 January our development team took the lead, with a staff introduction and surprising JavaScript lessons learned.